满血DeepSeek-R1的极速接入方式-火山方舟

URL Source: https://mp.weixin.qq.com/s/eRr74xPL54unc7-9WIQ9pA

最近一个月被DeepSeek R1天天刷屏后,很多人离了DeepSeek怕是都难以工作了。我一直以为用户量爆炸后,DeepSeek该离会��员制不远了,我还真就挺愿意花点钱去获得更稳定的服务的。但…看来Deepseek真是对整会员向用户收钱这事无动于衷啊,官网和app还在天天搁这繁忙呢~

所以,我上周也已经通过视频和公众号给大家推荐了

DeepSeek太卡了?这有5+1种DeepSeek R1最强满血替代方案等你查收!

因为DeepSeek是开源模型,有各种云服务厂商部署了他们的模型,通过API方式给用户提供服务,也有一些公司把DeepSeek R1接入了自己的产品,比如我上次文章中提到的AI编程工具Cursor、AI搜索产品Perplexity等。

不过,搜索、编程的使用场景毕竟还是受限,大家好像都更习惯通过chatbot的方式去使用deepseek的服务,于是各种云服务厂商引来了一波API使用用户量的爆炸,就看谁能接住这波deepseek溢出的泼天富贵了。

这几天关于哪家deepseek API服务商提供的服务更稳定、速度更快也是炒得好不热闹的。截至目前,我看到过的最公允的评测应该是「赛博禅心」公众号发出的:

从这个评测看的话,火山和硅基流动Pro版本应该是目前最值得选择的模型,DeepSeek官方确实还是有点拉垮,和我自己的体验基本一致。这个评测还挺厉害的,推荐大家都可以去看看。

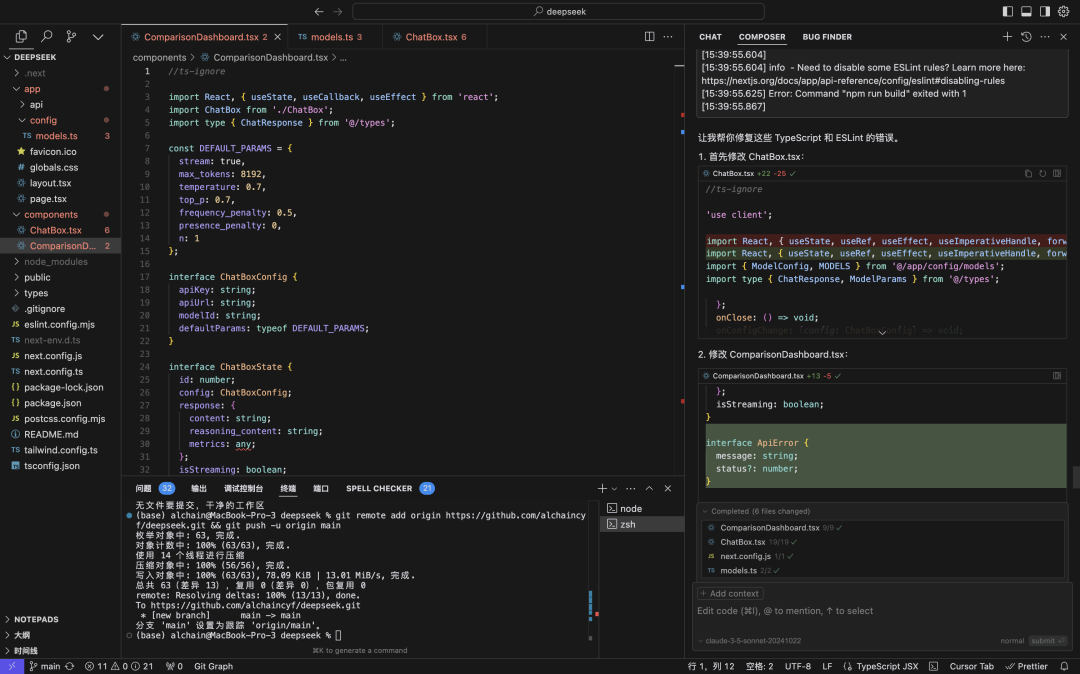

不过作为一个B站10万粉AI up主✌️,我对评测这事有点不一样的想法,我想试试怎么更视觉化的展现不同API平台的速率,而不只是看着这一串数字。于是,带着这该死的想法,我和Cursor折腾了大半天,整出了一个视觉化评测的小工具。

我们拿两个问题试试不同平台的表现究竟怎么样👇

为了体现模型的真实速度,这两个视频都没有做任何加速。这两次测试里最拉垮的都是deepseek官方的API,都直接不给我回复了😢,三个云厂商的API产品服务至少都算是稳定,可以持续输出。

相对来说目前的速率情况是火山和硅基流动Pro都还挺快的:火山方舟 > 硅基流动Pro > 阿里云百炼 >> DeepSeek官方。

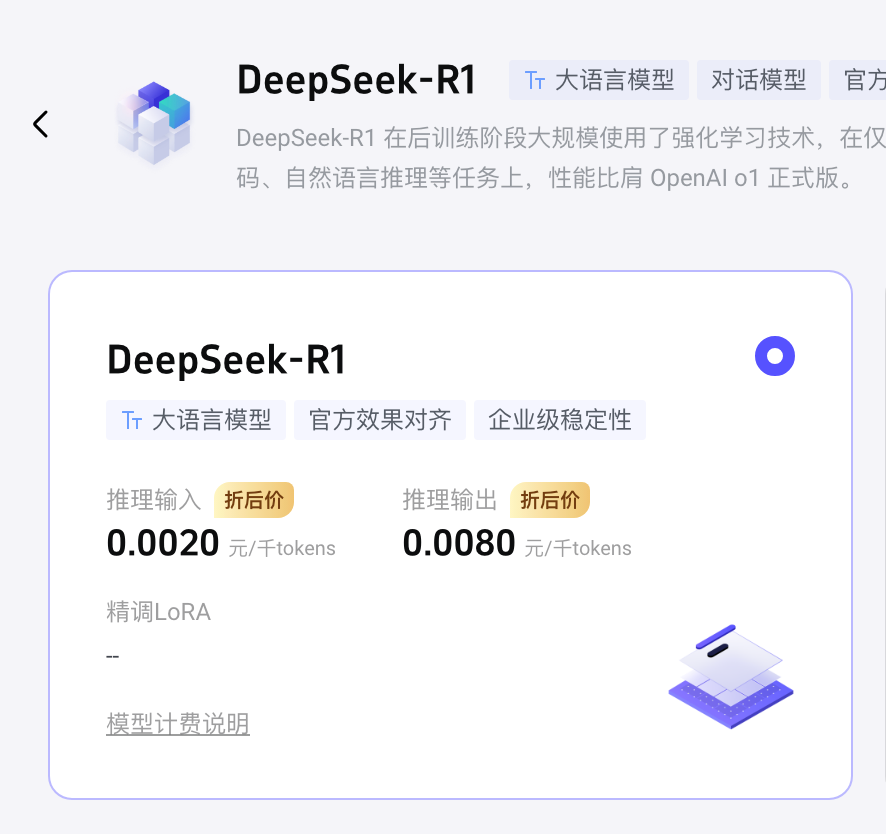

我又去字节的火山方舟平台看了下,一直到2月18号,火山的DeepSeek-R1和V3模型每百万token的输入和输出价格分别是2元和8元,是官方价格的一半,每个用户会有50万的免费token额度。

火山方舟的DeepSeek R1:https://console.volcengine.com/ark/region:ark+cn-beijing/model/detail?Id=deepseek-r1

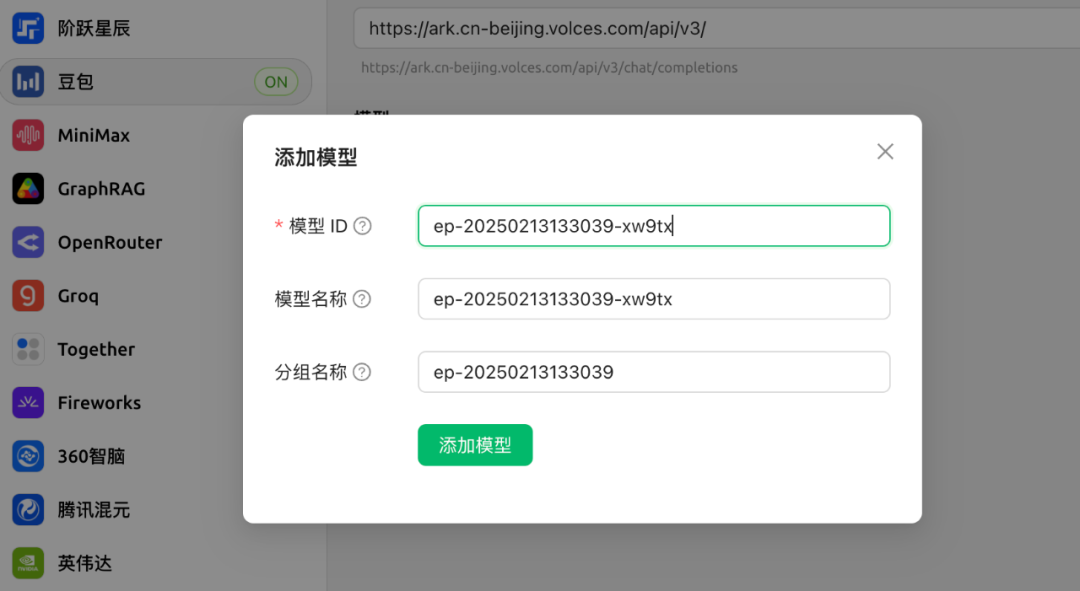

不过,有一点需要注意的是,调用火山方舟的deepseek模型的话你需要非常关注模型名称model,他们的规则和别的平台不太一样,model名称不是统一的DeepSeek-R1,而是你需要去创建一个自己的端点(Endpoint_id)

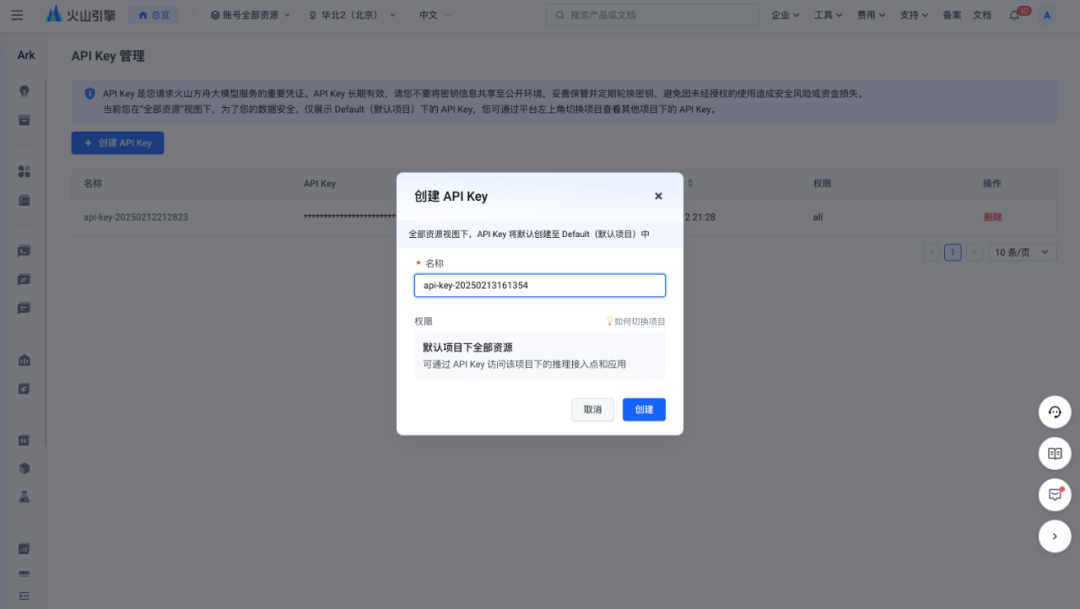

所以,你的操作步骤应该是:

1、到这个界面创建端点

https://console.volcengine.com/ark/region:ark+cn-beijing/endpoint

2、到这个界面创建API Key

https://console.volcengine.com/ark/region:ark+cn-beijing/apiKey

3、去对应的套壳产品填入API key和模型端点信息

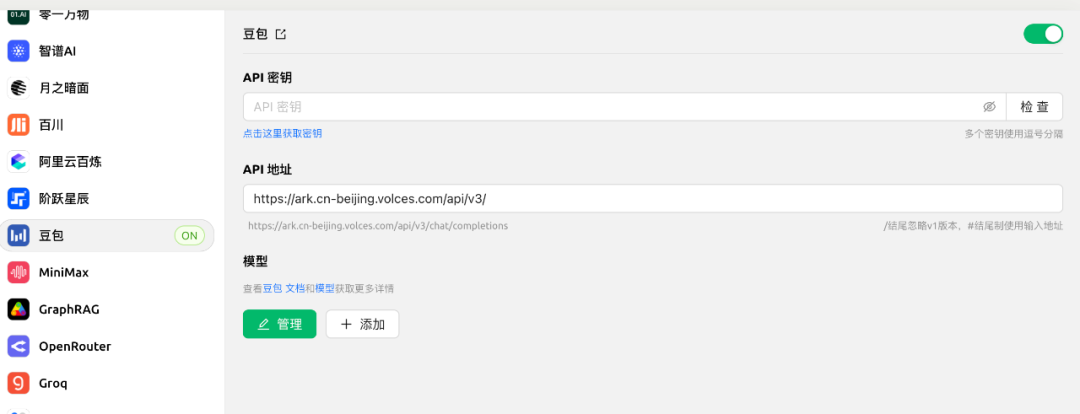

以CherryStudio为例的话,你需要在设置里找到「豆包」,然后在这个界面你除了需要输入API key之外,还要注意点击“添加”,把你在第1步获取的端点信息填写进去。

我们来感受下聊天过程有多丝滑👇